Le prestazioni della IA? Si testano con Super Mario

Non tutti gli esperti però pensano che un videogioco sia il mezzo migliore per valutare la bontà dei modelli.

[ZEUS News - www.zeusnews.it - 10-03-2025]

Qualche tempo fa Anthropic aveva rivelato che, per valutare le capacità di ragionamento della propria IA Claude 3.7, aveva utilizzato il videogioco Pokémon: in questo modo l'azienda poteva valutare la capacità del modello di trovare le soluzioni migliori.

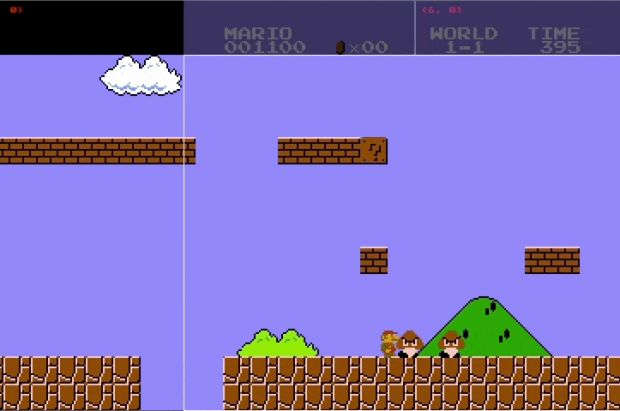

Ora però i ricercatori dell'Hao AI Lab (parte dell'Università della California a San Driego) sostengono che la scelta del gioco da usare per valutare la IA non sia stata vincente: sarebbe infatti stato meglio usare Super Mario Bros.

Per dimostrarlo hanno costretto quattro diversi modelli a giocare allo storico gioco o, meglio, a una sua incarnazione recente: tramite il framework GamingAgent hanno garantito alle quattro IA in questione il controllo di un clone di Super Mario.

Le IA messe alla prova sono state il già citato Claude 3.7, Claude 3.5, Gemini 1.5 Pro (Google) e GPT-4o (OpenAI).

I ricercatori hanno fornito le indicazioni di base - che cosa fare quando si incontra un ostacolo o un nemico - ma sostengono che ogni modello ha poi dovuto imparare da sé come gestire il gioco, sviluppando strategie complesse e adattandosi di volta in volta alle diverse sfide proposte dall'avanzamento di Super Mario nel livello.

Ed è qui che si dimostrerebbe la superiorità di Super Mario Bros su Pokémon come strumento per valutare le capacità della IA: un platform, infatti, richiede - sempre secondo i ricercatori lo sviluppo di manovre complicate e di diverse strategie di gioco, ma anche di reagire rapidamente alle situazioni.

Proprio quest'ultima caratteristica avrebbe causato la caduta dei modelli che "ragionano", come GPT-4o e Claude 3.7, rispetto a quelli standard: per arrivare al miglior risultato, il "ragionamento" richiede alcuni secondi per essere sviluppato; ma in un gioco come Super Mario anche un solo secondo può fare la differenza tra il completamento del livello e la perdita di una vita.

Ecco perché i modelli tradizionali nel test di Super Mario si sono comportati meglio: anche se più imprecisi rispetto ai loro colleghi più evoluti, hanno saputo avere tempi di reazione inferiori.

Non tutti gli esperti di IA sono però d'accordo con le conclusioni dei ricercatori californiani né, se è per quello, con quelle di Anthropic: ritengono infatti che la capacità di gestire un videogioco non sia poi così importante per definire la bontà di un modello di IA.

Richard Socher, ex responsabile della IA per Salesforce e fondatore di You.com, ha di recente commentato: «Penso proprio che i giochi tendano a entusiasmare parecchio le persone, che è qualcosa in cui si possono immedesimare. Hanno giocato a quei giochi e si ricordano quant'erano difficili. Ma è un po' come entusiasmarsi perché un computer sa moltiplicare numeri molto grandi: alla fine quei sistemi non sono poi così intelligenti. Non si crea un vero valore, al di là del gioco».

Anche Andrej Karpathy, di OpenAI, ha dubbi in proposito: «La mia reazione è che ci sia una crisi di valutazione» ha scritto su X. «Non so proprio quali metriche considerare in questo momento».

Se anche gli esperti non sono d'accordo su ciò che consente di definire "efficace" una IA diventa particolarmente difficile credere agli annunci del marketing e alle promesse che tutti gli attori del settore fanno quasi quotidianamente.

|

Se questo articolo ti è piaciuto e vuoi rimanere sempre informato con Zeus News

ti consigliamo di iscriverti alla Newsletter gratuita.

Inoltre puoi consigliare l'articolo utilizzando uno dei pulsanti qui

sotto, inserire un commento

(anche anonimo)

o segnalare un refuso.

© RIPRODUZIONE RISERVATA |

|

Il Game Boy compie 25 anni

Commenti all'articolo (1)

10-3-2025 09:23

|

|

||

|

- Windows 11, 10:

PC IN UFFICIO con 11 in panne bloccato aiuto!!!! - Programmazione:

Formattare correttamente un float - Al caffe' dell'Olimpo:

[GIOCO] Il Bersaglio - Linux:

Skype su Antix - Internet - generale:

Account Instagram sospeso non so come

riattivarlo!!!!!!!!!! - Bufale e indagini antibufala:

StopFake oppure no? - Il salotto delle Muse:

Sanremo League - Vecchi articoli di Zeus News:

Errori negli articoli - Olimpo.TV:

Warner TV? No, Warning TV - Periferiche esterne:

Ok consiglio per hard disk esterno forse SSD

Homer S.